来源 | 同济智能汽车研究所(动力掌握研究室)

知圈 | 进“底盘社群”请加微yanzhi-6,备注底盘

编者案:多目标的跟踪是主动驾驶范畴常见的研究问题,而目前简单基于卡尔曼滤波的跟踪办法难以包管足够的精度,且在数据联系关系阶段和汗青轨迹生命周期治理器方面存在很大的提拔空间。因而做者提出了一个包罗多个神经收集模块的多模态多目标跟踪模子,合成2D图像和3D激光点云的特征来同时操纵目标的外看信息和几何信息,并操纵神经收集计算双模子的连系权重和揣度新目标能否能够间接生成新轨迹。综合来看,做者提出的多模态跟踪办法足够合成了图像和点云的信息,并引进神经收集动态获取本来提早设定的超参数,在KITTI跟踪数据集上获得了领先的性能。

摘要:多目标跟踪是主动驾驶车辆在交通场景中平安行驶的重要功用。当前更先进的办法遵照“检测-跟踪”范式,此中当前跟踪目标物通过一些间隔目标与检测目标物相联系关系。进步跟踪准确性的关键挑战在于数据联系关系和跟踪生命周期治理。我们提出了一种基于概率的、多模态、多目标的跟踪系统,该系统由差别的可操练模块构成,以供给鲁棒的和数据驱动的跟踪成果。起首,我们进修若何合成2D图像和3D激光雷达点云的特征,以捕获目标的外看和几何信息。第二,在比力数据联系关系中的跟踪目标和新检测目标时,我们提出一种连系马氏间隔和特征间隔的目标。第三,我们提出了一个何时从未婚配的目标检测中初始化跟踪使命的办法。通过普遍的定量和定性成果,我们表白,当利用不异的目标检测器时,我们的办法优于NuScene和KITTI数据集上的更先进办法。

Ⅰ 绪论

3D多目标跟踪关于主动驾驶至关重要。它能够估量所有交通参与者的位置、标的目的和尺寸。通过考虑时间信息,跟踪模块能够从基于帧的目标检测中过滤反常值,而且对部门或完全遮挡愈加鲁棒。然后,所得轨迹可用于揣度每个交通参与者的运动形式和驾驶行为,以改进运动揣测。那能够在主动驾驶中实现平安决策。

当前更先进的3D多目标跟踪[1, 2]遵照“检测-跟踪”范式。那些办法起首利用3D目标检测器来估量每帧中每个目标的鸿沟框的位置和标的目的。然后,他们利用中心或马氏间隔[3]做为检测目标物和现有跟踪目标物之间的数据联系关系目标。然而,那些目标仅评估目标的间隔以及鸿沟框大小和标的目的的差别,而漠视每个目标的几何和外看特征。因而,数据联系关系性能高度依靠运动揣测的准确性。关于难以切确揣测的物体,例如行人、摩托车或急转弯的汽车,揣测和准确检测之间的欧氏间隔可能很大。因而,它们可能无法准确婚配。[4, 5]试图通过从跟踪器的轨迹和检测的特征进修联系关系目标来改进数据联系关系。然而,那些办法仍然无法超越上述基于中心间隔的简双方法[1]。成果表白,成立有效数据联系关系的神经收集具有挑战性。

我们定见在比力跟踪和检测之间的数据联系关系时,进修若何权衡马氏间隔和基于几何和外看特征的间隔[3]。那些特征是从3D激光雷达点云和2D相机图像中提取的。与[4]和[5]差别,我们在原则卡尔曼滤波器[6]中利用进修到的目标,那种卡尔曼滤波器对多目标跟踪有效[2]。此外,卡尔曼滤波器供给了可阐明性和显式的不确定性估量,可用于下流决策。

除了数据联系关系,跟踪目标物的生命周期治理是在线目标跟踪系统的另一个重要构成部门。跟踪目标物的生命周期治理确定何时初始化和末行每个跟踪使命。那一决定会显著影响假阳性和ID切换的数量。然而,跟踪目标物的生命周期治理并没有引起研究界的太多存眷。先前的工做要么为每个未婚配的检测目标物初始化一个新的跟踪使命[1],要么创建暂时跟踪使命,并在足够持续的婚配情状下将其转换为完全轨迹[2, 4, 5, 7, 8]。

基于其几何和外看特征,我们提出了一种能否从未婚配检测目标物中初始化新跟踪使命的办法。那种办法有助于制止我们的跟踪办法为潜在的假阳性初始化新的跟踪使命。

总而言之,我们提出了一种基于概率的、多模态、多目标的跟踪系统,该系统由三个可操练模块(间隔组合、跟踪初始化和特征合成)构成,以供给鲁棒的和数据驱动的跟踪成果。我们在NuScenes [9]和KITTI [10]数据集上利用领先的目标检测器[1, 11]评估了我们的办法,那些目标检测器将3D激光雷达点云做为输进。我们表白,所提出的办法优于[1]和[5]中陈述的跟踪办法。通过有效合成2D和3D输进,我们能够进一步进步性能。我们的定性成果还明白展现出假阳性跟踪的削减,那对决策很重要。假设利用愈加新的目标检测器,我们估量会进一步进步性能,因为我们的办法对抉择哪个目标检测器事先未知。

Ⅱ相关工做

A. 3D 目标检测

大大都的3D多目标跟踪系统[1, 2, 4, 5, 7, 8, 12],在由3D目标检测器供给的目标检测框长进行跟踪。因而,3D目标检测器的抉择关于整个跟踪系统的性能是很重要的。3D目标检测能够被利用于相机图像[13, 14],激光雷达点云[11, 15-19],或者他们的连系上[20-22]。单目3D目标检测性能不太可能与操纵激光雷达或深度信息的模子持平。因而,依靠单目3D目标检测器的3D多目标跟踪算法[12, 23]凡是无法胜过依靠激光雷达或基于深度的目标检测器的跟踪办法。

在我们提出的跟踪系统中,我们利用CenterPoint 3D目标检测器[1],它是NuScenes检测数据集[9]中表示更好的检测器之一。需要重视的是,我们的办法与检测器无关。CenterPoint 量化激光雷达点云并利用PointNet [24, 25]生成特征图。然后将特征图输进到关键点检测器,用于定位对象的中心并**鸿沟框的大小和标的目的。

B. 3D 多目标跟踪

大大都3D多目标跟踪算法摘用先检测后跟踪的框架。他们将 3D 对象检测成果做为跟踪办法的输进。在数据联系关系步调中,利用差别的间隔度量来找到婚配的轨迹检测对。例如,AB3DMOT [7]在2D跟踪算法[26]中利用3D交并比(3D IOU)做为2D交并比的扩展。ProbabilisticTracking [2]利用马式间隔,它考虑了跟踪形态的不确定性。CenterPoint [1]利用目标的中心间隔并实现了有合作力的跟踪性能,那次要是因为新提出的3D目标检测器比[2, 7]中利用的检测器更好。CenterPoint [1]目前是NuScenes跟踪数据集[9]中更先进的办法之一。

其他几种3D跟踪办法提出将跟踪的轨迹与对象几何和外看特征相连系。GNN3DMOT [5]利用图神经收集和2D-3D多特征进修停止数据联系关系。PnPNet [4]提出了一个端到端的可操练模子来结合处理检测、跟踪和揣测使命。然而,他们无法在NuScenes [9]数据集上胜过上述更简单的CenterPoint [1]算法。

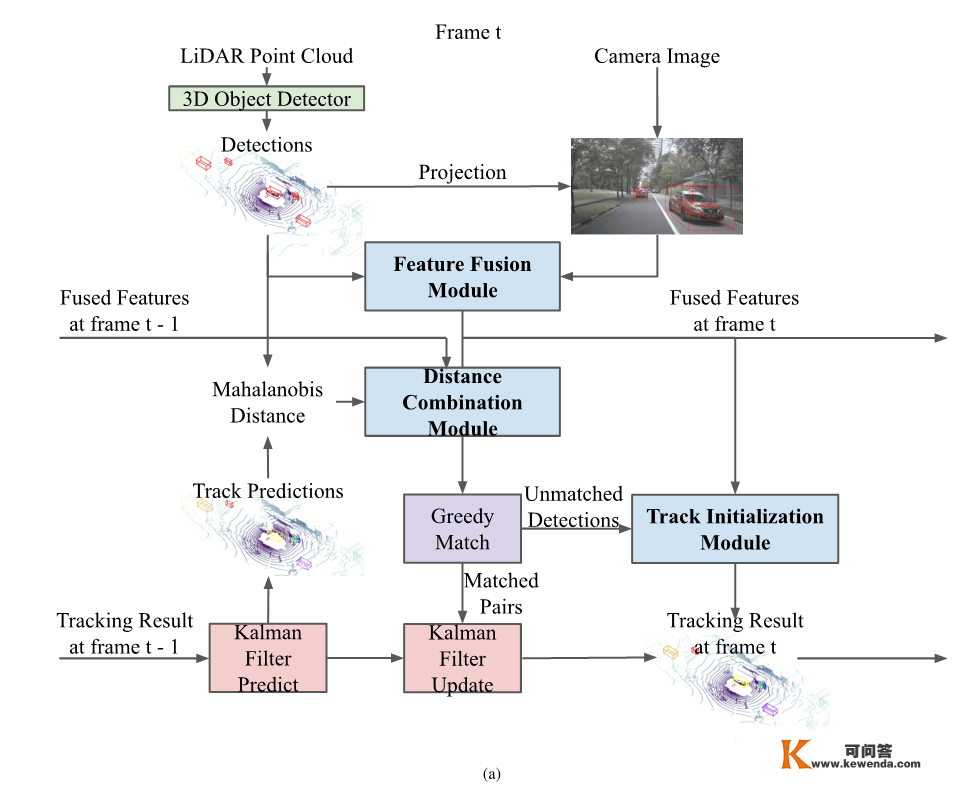

图1:算法流程图。子图(a)描述了我们提出的架构的高级概述,右侧的(b)(c)(d)表白了每个神经收集模块的细节。在第t帧,我们利用3D物体检测器并提取每个检测到的目标的激光雷达和图像特征。那些特征是由特征合成模块合成的。时间t的检测特征和时间t-1的跟踪特征合成后的特征被用在可操练间隔组合模块中,以进修深度特征间隔和Mahalanobis间隔的组合。我们将贪婪婚配算法利用于数据联系关系的组合间隔,婚配得到的物体对由卡尔曼滤波器进一步处置以细化最末对象形态。轨道初始化模块决定能否为每个不婚配的检测初始化新的跟踪。

Ⅲ办法

我们的办法的流程如图1所示。在ProbabilisticTracking [2]的根底上,我们的算法将激光雷达点云和相机图像做为输进,并通过卡尔曼滤波器停止目标跟踪。我们提出的跟踪算法具有三个可操练的组件,以加强数据联系关系和跟踪生命周期治理:特征合成模块合并激光雷达和图像的特征以生成合成后的深层特征。间隔组合模块将深层的特征间隔与马氏间隔相连系,做为数据联系关系的最末度量。此外,我们还引进了轨迹初始化模块,该模块根据合成的2D和3D深度特征来决定能否为每个未婚配的检测目标初始化新轨迹。鄙人面的内容中,我们将描述我们提出的跟踪模子的每个核心组件。

A. 卡尔曼滤波

我们在ProbabilisticTracking [2]之前的工做根底上,利用卡尔曼滤波器[6]停止对象形态估量。每个对象的形态由11个变量表达:

此中为物体3D边框的中心位置,为物面子向标的目的与轴的夹角,表达边框的长、宽、高,表达当前帧与前一帧的差值。

我们利用线性运动模子对运动物体的动力学停止建模,并假设线性速度和角速度恒定,物体尺寸恒定,即在揣测步调中不发作改变。根据原则的卡尔曼滤波公式,我们将揣测步调定义为:

此中,为时刻实在形态的估量均匀值,为时刻的揣测形态均匀值。矩阵为流程模子的形态转移矩阵。矩阵是时刻的形态协方差,而是时刻的揣测形态协方差。矩阵是过程模子噪声协方差。

我们利用CenterPoint [1]的3D物体检测器为我们的卡尔曼滤波器供给看测。每帧3D物体检测成果由一组3D鸿沟框构成,每个鸿沟框由9个变量表达:

此中为检测框的中心位置、标的目的和比例,类似于式1中的定义。剩下的两个变量表达当前帧和前一帧之间的差值。那两个值能够通过将检测器的估量中心速度与两个持续帧之间的时间继续时间相乘得到。我们利用均值为零、噪声协方差为的加性高斯噪声的线性看察模子,操纵该看测模子和揣测的目标形态为,我们能够揣测下一个丈量值为立异协方差为,表达揣测目标检测的不确定性:

过程模子和看测模子的噪声协方差矩阵和是根据操练集数据的统计估量的,如[2]中提出的。

B. 2D和3D特征的合成

该模块旨在合成来自2D相机图像和3D激光雷达点云的特征,每次检测的关键帧。合成的特征将被用做间隔组合模块和轨迹初始化模块的输进。关于每个检测,我们起首将其2D位置从世界坐标系映射到3D对象检测器中间特征映射坐标系中的2D位置。从中间特征图中提取的激光雷达点云特征。我们不再只提取特征图中位于的单个特征向量,而是提取认为中心的相关区域内的所有特征向量,以便当用更多的上下文信息。

然后将三维检测鸿沟框投影到摄像机图像平面上,从COCO [27]预操练掩码R-CNN[28]中提取响应的二维图像特征。关于每个投影的2D鸿沟框,我们提取一个2D图像特征,该特征未来自投影2D鸿沟框的RoIAlign特征的1024维向量和一个6D one-hot向量毗连起来,该向量表达物体投射到哪个相机平面(在传感器扫描的6个平面中)。

最初,我们通过多层感知器(MLP)和一个重塑操做将两个特征向量合并:

此中是个检测的合成特征; 为2D特征; 为3D特征;表达MLP和图1b所示的重塑操做。该MLP的隐躲大小为1536,输出大小为4608,利用整流线性单位(ReLU)做为激活函数。重视,我们不但独操练那个特征合成模块。相反,我们将其毗连到间隔组合模块和轨迹初始化模块,并利用那两个模块停止操练。

C. 间隔联系关系模块

该模块为个检测成果和个轨迹之间的数据联系关系供给了一个可进修的间隔度量。该度量连系了来自形态估量以及外看和几何特征的信息。详细来说,我们设想了马氏间隔和深度特征间隔的线性组合:

此中,表达马氏间隔矩阵,此中每个元素包罗每个检测成果和每个航迹揣测形态之间的间隔;表达特征间隔矩阵,其元素权衡每个检测和每个航迹之间的特征不类似度,为合并系数矩阵,其外形为。符号表达元素级乘积算子。常数做为线性组合的初始偏置项,搀扶帮助模子操练更快地收敛。的每个元素的计算公式为:

此中,为第个检测值,定义在方程4中,为线性看测模子,为第轨揣测形态均值,为信息协方差矩阵,定义在方程6中。

摘用如图1c所示的两阶段神经收集操练办法,起首进修深度特征间隔,然后进修系数矩阵,生成最末的结合间隔度量。

1)深度特征间隔:收集从个检测和个轨迹的合成特征中进修一个的间隔图:

此中,如图1c所示,表达一个核大小为,输出通道大小为256的卷积层,后接一个ReLU层和一个隐躲大小为128的MLP层。我们将特征间隔进修做为一个二分类问题来处置,而且我们用二进造穿插熵缺失来操练收集。

此中是监视婚配指示矩阵,此中0表达婚配的航迹-检测特征对,1表达不婚配的特征对。因为每个航迹-检测对没有地物标注,假设前一帧中跟踪框最靠近的地物框和当前帧中检测框最靠近的地物框属于统一个目标标识,且它们与最靠近的地物框的2D中心欧氏间隔均小于2米,则将该对视为婚配。

2)组合系数:固定进修到的特征间隔,然后操练间隔组合模块的剩余部门来进修系数矩阵和,从而根据每个深度特征间隔的重要性来调整最末的间隔D。

此中表达图1c中的卷积层和MLP层。具有与类似的收集构造,只是输出信道大小差别。受PnPNet [4]的启发,我们连系更大间隔和比照缺失来操练那个模块。关于一对正样本和负样本,我们定义其更大间隔缺失如下:

此中为常数间隔,为正样本的组合间隔,为负样本的组合间隔,见公式8中的间隔矩阵。整体的比照缺失给出如下:

此中表达正的航迹检测对聚集,表达负的航迹检测对聚集。那种缺失函数的设想鼓舞神经收集通过调整和的元素,进修为每个正轨检测样本生成一个小于任何负样本的间隔的间隔。

为了在推理时也利用进修到的组合间隔来舍弃不婚配的反常值,我们为正样本集和负样本集定义了别的两个更大的边际缺失:

此中,和表达固定的边际,是用于在推理时舍弃不婚配的反常值的恒定阈值。那种缺失函数的设想鼓舞神经收集对任何正样本产生一个小于阈值的间隔,对任何负样本产生一个大于的间隔。

该神经收集的总体操练缺失定义如下:

在我们的实现过程中,抉择,与[2]中利用的阈值不异。设置,大约是的一半。同时,我们设置,是的一半。

在测试时,一旦我们计算出综合间隔,我们就利用ProbabilisticTracking [2]的贪婪婚配算法停止数据联系关系。

D.轨迹初始化模块

轨迹生命周期治理是多目标跟踪系统的另一个重要构成部门。大大都先前的工做要么老是为每个不婚配的检测初始化一个新的轨迹[1],要么创建一个暂时轨迹,然后在将暂时轨迹转换为完全的轨迹之前期待一个固定命量的持续婚配[2, 7, 8]。

与之前的启发式办法差别,我们将轨迹初始化使命视为一个二元分类问题。我们提出了轨迹初始化模块,该模块将不婚配的检测记过的合成特征 做为输进,并就能否应该初始化一个新的轨迹生成一个输出信度分数 :

此中,表达图1d中描述的卷积层、MLP和Sigmoid层。其卷积层与MLP层的构造与。我们利用穿插熵缺失将操练成一个二元分类器:

此中, 假设有一个接近检测目标的空中实在物体,则;不然。在推理时间,假设大于0.5,我们会利用新的跟踪器来初始化不婚配的检测。那个轨迹初始化模块搀扶帮助我们提出的跟踪系统削减了假阳性轨迹的数量,如图2所示。

Ⅳ尝试成果

A. 数据集

我们在NuScenes[9]和KITTI[10]数据集上评估我们的办法。NuScenes数据集包罗1000个驾驶序列。每个序列的长度大约为20秒,包罗以2Hz摘样的关键帧。我们遵照官方的数据朋分设置,用700个序列操练我们的模子,并陈述150个验证序列的成果。关于KITTI数据集,我们遵照GNN3DMOT[5]的朋分设置,此中包罗10个操练序列和11个验证序列。在所有的尝试中,我们通过利用Adam[29]优化器来操练我们的模块,初始进修率为0.001,历时10个周期。

B.评估目标

为了评估我们的算法性能,我们利用均匀多目标跟踪精度(Average Multi-Object Tracking Accuracy, AMOTA),那也是NuScenes跟踪挑战(The NuScenes Tracking Challenge [9])中利用的次要评估目标。AMOTA是差别召回阈值下的跟踪精度均匀值,定义如下:

此中为摘样点数,是抽样召回阈值。MOTAR (Recall-Normalized Multi-Object Tracking Accuracy) 是召**一化多目标跟踪精度,定义如下:

此中为实阳性数,为身份开关数,为假阳性数,为假阴性数。

关于KITTI [10],我们还陈述了原则的多目标跟踪精度(Multi-Object Tracking Accuracy, MOTA),定义如下:

此中, 和是在单一更佳召回阈值摘样的身份开关、假阳性和假阴性的数量。

C.定量成果

我们在表Ⅰ中陈述了我们的办法在NuScenes验证集中验证的成果。我们提出的跟踪办法利用CenterPoint[1]在每帧的3D对象检测成果做为卡尔曼滤波器的输进。为了与更先进的办法[1, 2, 7]停止公允的比力,我们还将我们的跟踪办法在仅利用激光雷达做为输进时的定量成果包罗了进往。从表Ⅰ能够看出,输进检测的量量对最末的跟踪性能至关重要。在NuScenes检测挑战[9]中,CenterPoint [1]供给了比MEGVII [15]更好的3D对象检测成果。

从表Ⅰ的最初两行能够看出,当只利用完全不异的3D激光雷达输进时,我们的跟踪办法优于CenterPoint [1]和ProbabilisticTracking [2]。我们的模子可以利用3D激光雷达点云数据进修细粒度的几何特征,而且我们的模子还胜利地进修了几何特征间隔和马氏间隔的有效结合权重。此外,通过合成来自激光雷达和图像数据的特征,我们的办法能够进一步进步整体AMOTA,与之前更先进的CenterPoint [1]比拟,性能进步了2.8。那一性能增益表白,我们的模子可以进修若何有效地将3D 激光雷达点云信息和2D相机图像信息输进合成在一路,以实现更好的整体跟踪精度。然而,我们的模子并没有实现对行人跟踪的显著改进。那可能是因为每个行人的外形和几何特征跟着时间的推移会发作浩荡改变,因为他们的姿势会发作改变,而其他对象没有变形。

我们还将我们的模子与其他多形式跟踪模子停止了比力:GNN3DMOT [5]和PnPNet [4]在NuScenes [9]中的验证成果(表Ⅱ)和KITTI [10]中的验证成果(表Ⅲ)。

表I:NuScenes [9]验证集的评估成果。与基线办法比拟,根据每个目标类此外总体AMOTA和单个AMOTA停止评估。在每一列中,获得的更佳成果都用粗体字展现。(*通过利用[2]的开源代码和[1]的对象检测成果实现的。)

表II:NuScenes [9]验证集的评估成果,整体AMOTA和汽车AMOTA的评估。GNN3DMOT [5]仅陈述了整体AMOTA,PnPNet[4]仅陈述汽车的AMOTA。重视,每种办法利用一个差别的3D目标检测器,那可能会显著影响跟踪精度。(*GNN3DMOT [5]在他们的论文中将AMOTA重定名为sAMOTA。)

表III:KITTI [10]验证集的评估成果,汽车AMOTA和MOTA方面的评估。我们遵照[5],利用Point R-CNN [11] 3D目标检测器和不异的操练验证数据划分。(*GNN3DMOT [5]在他们的论文中将AMOTA重定名为sAMOTA)

D.消融研究

我们供给了差别可操练模块的消融阐发,以更好天文解它们对整系统统性能的奉献:间隔组合模块、轨迹初始化模块和特征合成模块。我们在表Ⅳ中陈述了我们的成果。我们重视到,间隔组合模块和轨迹初始化模块在基线上产生了一致的改进,在同时启用那两个模块时到达了更高的性能点。此外,在合成2D和3D特征时,我们笔录了性能的继续增长,那使我们能够得出结论,我们的模子胜利地学会了若何操纵外看和几何特征。

表IV:NuScenes [9]验证集的消融试验成果。与我们提出的办法的变体比拟,根据每个对象类此外整体AMOTA和单个AMOTA停止评估。所有变体都利用CenterPoint [1]的对象检测成果做为输进。在每一列中,获得的更佳成果都用粗体字展现。

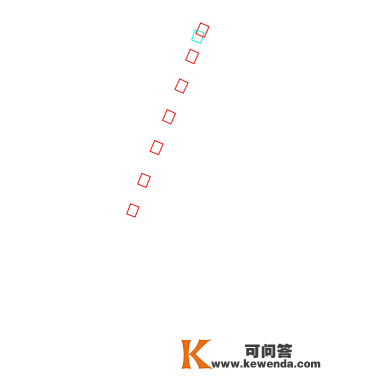

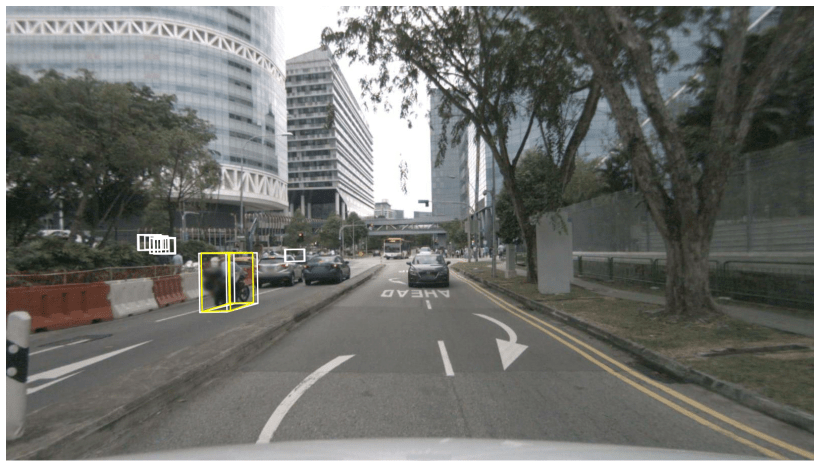

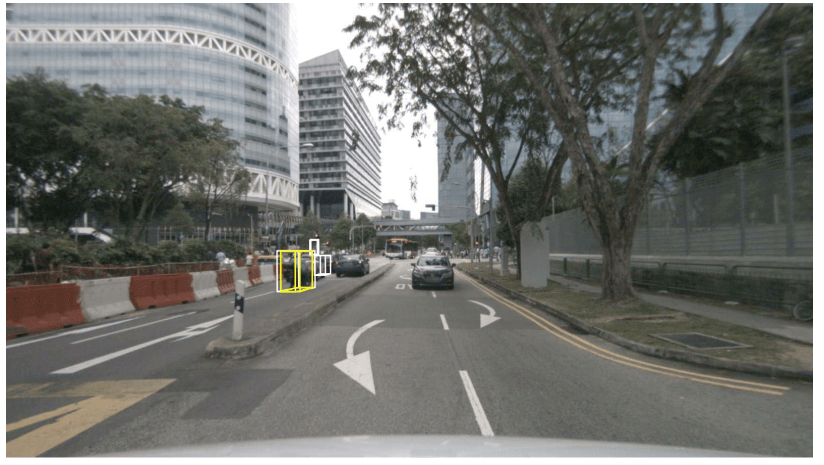

(a) 输进的检测

(b)CenterPoint [1]

(c) 我们提出的办法

(d) 实值

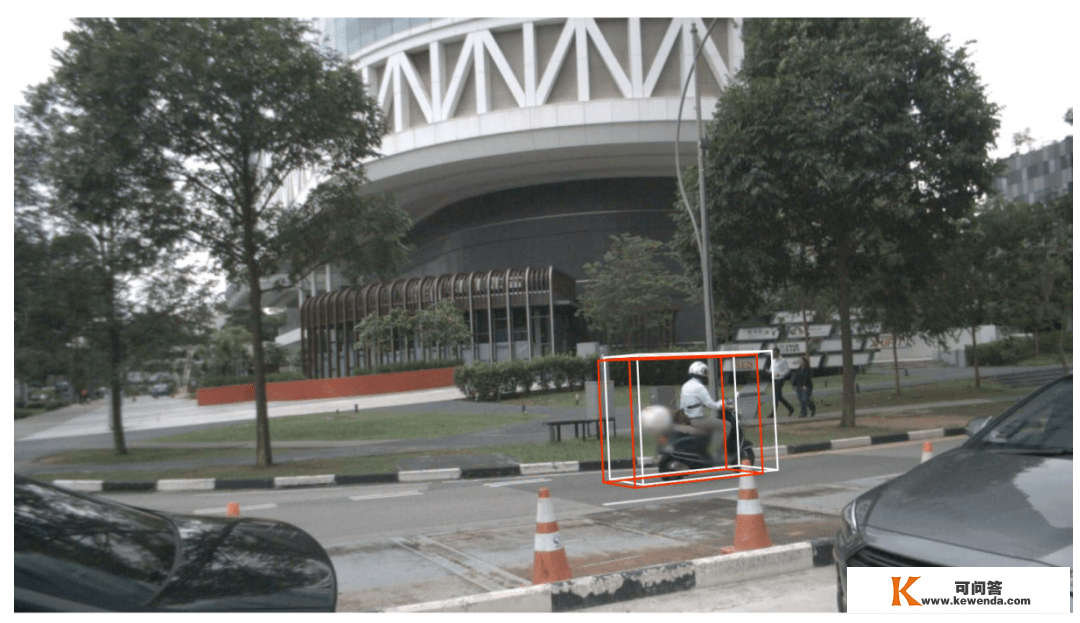

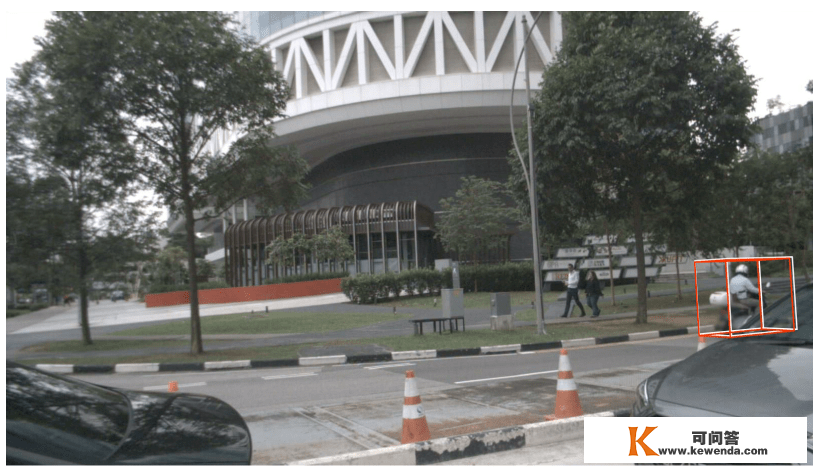

图2:摩托车的鸟瞰跟踪成果可视化。我们绘造了每个子图中不异驾驶序列的每个帧的鸿沟框,差别的颜色表达跟踪成果中差别的跟踪id,同时表达实值标注中目标的差别实例。(a):输进是CenterPoint [1]的对象检测器供给的检测鸿沟框。(b):CenterPoint [1]的跟踪成果。(c):我们提出的办法的跟踪成果。(d):实在值。与CenterPoint [1]的成果比拟,我们的跟踪成果明显具有更少的假阳性鸿沟框,我们的逃踪成果也更接近于实值。

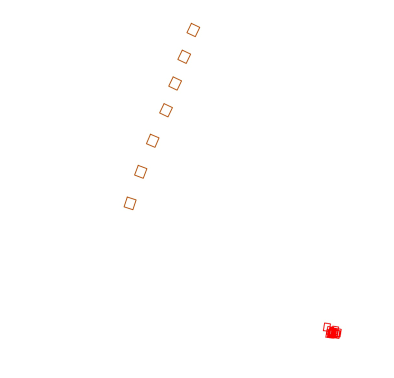

(a) 序列0, 帧1

(b) 序列0, 帧2

(c) 序列1, 帧28

(d) 序列, 帧29

图3:投影到摄像机图像的摩托车跟踪可视化。(a) 、(b)是序列0中的两个持续帧,(c)、(d)来自序列1。彩色框是跟踪成果,差别的颜色表达差别的跟踪id,白色框表达检测成果。我们的模子能够准确跟踪序列0中红色鸿沟框和序列1中黄色鸿沟框中的摩托车。在序列0中,我们的间隔组合模块进修生成更大的正α值为2.594,那可能是因为外看特征供给了强大的信息,以婚配那些持续帧中检测到的摩托车。在序列1中,我们的模子生成了更小α值为1.802,那可能是因为鸿沟框更小,图像更模糊。我们的轨道初始化模块也准确地决定了不合错误序列1帧28中的假阳性检测初始化新的跟踪。

E.定性成果

如表I所示,我们重视到特定类此外显著改进(如:摩托车类别超越10%)。在图2中,我们绘造了BEV上不异驾驶序列的每一帧中摩托车的鸿沟框,差别颜色的图像表达差别的跟踪id,并与办法[1]停止比力。从图2能够看出,与[1]比拟,我们的跟踪成果具有明显更少的假阳性鸿沟框。办法CenterPoint [1]依靠于中心欧几里德间隔,任何不婚配的检测框老是被初始化为新的跟踪。相反,我们的跟踪初始化模块被设想为基于3D激光雷达和2D图像特征的合成来决定能否初始化新的跟踪。此外,我们的办法利用卡尔曼滤波器基于过往的看测来细化鸿沟框位置、标的目的和标准,而[1]间接利用潜在噪声检测框做为跟踪成果,而不利用过往的看测。

固然我们在数量上笔录到,与CenterPoint [1]比拟,摩托车类的AMOTA增加了11.0%,但从量量上来说,那意味着假阳性跟踪的数量显著削减,固然AMOTA度量没有过多赏罚,但那对决策至关重要。定性和定量成果之间的差别背后的次要原因是,大大都假阳性跟踪是由具有低置信分数的假阳性检测框构成的。AMOTA起头从那些具有较高置信分数的人身上取样,因而,大量置信度低的假阳性跟踪不会对AMOTA产生太大影响(有关AMOTA的详尽信息,请参考[9])。

图3展现了我们将摩托车投影到相机图像上的成果。(a),(b)是序列0中的两个持续帧。(c),(d)来自序列1。白色框表达检测框,彩色框表达用彩色编码的跟踪ID的跟踪成果。我们的模子在两个序列中都能切确跟踪摩托车,在序列0中,我们的间隔组合模块对履带摩托车揣测出了一个较大的正α值为2.594,代表一个可靠的特征间隔。那是能够预期到的,因为在2D图像中对应的对象很大且能够清晰地捕获到。在对象较小且模糊的序列1中,模块揣测了一个较小的α值为1.802。此外,我们的跟踪初始化模块还准确地决定了不合错误序列1帧28中的假阳性检测初始化新的跟踪。

Ⅴ结论

在本文中,我们提出了一种用于主动驾驶的在线概率、多模态、多目标跟踪算法。我们的模子进修合成2D相机图像和3D激光雷达点云特征。然后,那些合成的特征被用于进修有效的权重,以将深度特征间隔与Mahalanobis间隔相连系,从而获得更好的数据联系关系。我们的模子还进修以数据驱动的体例治理跟踪轮回周期。我们在NuScenes [9]和KITTI [10]数据集上验证了我们提出的办法,我们的办法在定量和定性上都优于利用不异目标检测器的更先进的基准办法。

关于将来的工做,我们期看包罗额外的形式(如:地图数据)以及新型物体检测器。同时,每个类别进修更好的运动模子也有可能进一步改进数据联系关系。最初,我们或答应以操纵可微滤波框架端到端地微调运动和看测模子。

本文译自:

《Probabilistic 3D Multi-Modal, Multi-Object Tracking for Autonomous Driving》

文章来源:

2021 IEEE International Conference on Robotics and Automation (ICRA)

做者:

Hsu-kuang Chiu, Jie Li, Rares, Ambrus, Jeannette Bohg.

原文链接:

参考文献